怎样提取网页上的所有链接?

在浏览网页时,我们经常会遇到需要提取页面中所有链接的情况,无论是为了数据收集、网页爬虫开发,还是简单的信息筛选,掌握这一技能都至关重要。本文将详细介绍几种常用的方法,帮助你高效获取网页中的全部链接,同时确保内容结构清晰,关键词布局合理,以提高阅读体验和搜索引擎友好度。

初步准备

1. 确定工具与环境

首先,你需要选择一个合适的工具或编程语言。常见的选择包括Python、JavaScript(特别是在浏览器环境中使用),以及一些现成的网页爬虫工具如Scrapy、BeautifulSoup(Python库)、Selenium等。这些工具各有优势,根据需求选择即可。

2. 理解网页结构

网页通常由HTML、CSS和JavaScript组成。链接大多以``标签的形式存在于HTML中,其`href`属性指向链接的目标地址。了解这一点对后续提取链接至关重要。

使用Python与BeautifulSoup

Python凭借其丰富的库和简洁的语法,成为抓取网页信息的首选语言之一。BeautifulSoup是Python中用于解析HTML和XML文档的库,非常适合提取链接。

步骤一:安装必要的库

```bash

pip install requests beautifulsoup4

```

步骤二:编写脚本

```python

import requests

from bs4 import BeautifulSoup

目标URL

url = 'http://example.com'

发送HTTP请求获取网页内容

response = requests.get(url)

检查请求是否成功

if response.status_code == 200:

使用BeautifulSoup解析HTML

soup = BeautifulSoup(response.content, 'html.parser')

查找所有标签

links = soup.find_all('a')

提取并打印链接

for link in links:

href = link.get('href')

if href:

print(href)

else:

print('Failed to retrieve the webpage')

```

使用JavaScript(在浏览器环境中)

如果你更熟悉前端开发,或者需要在浏览器内直接操作DOM来提取链接,JavaScript是一个不错的选择。这里主要介绍在浏览器控制台中进行操作的方法。

步骤一:打开开发者工具

在现代浏览器中(如Chrome、Firefox),按F12或右键点击页面选择“检查”来打开开发者工具。

步骤二:执行JavaScript代码

在控制台(Console)中输入以下代码:

```javascript

// 获取所有标签

let links = document.querySelectorAll('a');

// 遍历并打印链接

links.forEach(link => {

let href = link.getAttribute('href');

if (href) {

console.log(href);

});

```

这种方法适用于快速检查当前页面上的链接,但不适合批量处理或自动化任务。

使用Selenium进行更复杂的抓取

Selenium是一个自动化测试工具,但同样可以用于网页抓取。它支持多种浏览器,并能处理JavaScript渲染的内容,非常适合抓取动态网页。

步骤一:安装Selenium和浏览器驱动

```bash

pip install selenium

```

此外,你需要下载与浏览器版本匹配的WebDriver(如ChromeDriver)。

步骤二:编写脚本

```python

from selenium import webdriver

from selenium.webdriver.common.by import By

设置WebDriver路径(以Chrome为例)

driver_path = '/path/to/chromedriver'

初始化WebDriver

driver = webdriver.Chrome(executable_path=driver_path)

打开目标URL

driver.get('http://example.com')

等待页面加载(根据需要调整)

这里可以使用显式等待来提高稳定性

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

wait = WebDriverWait(driver, 10)

element = wait.until(EC.presence_of_element_located((By.TAG_NAME, "body")))

获取所有标签

links = driver.find_elements(By.TAG_NAME, 'a')

提取并打印链接

for link in links:

href = link.get_attribute('href')

if href:

print(href)

关闭浏览器

driver.quit()

```

注意事项与优化

1. 遵守robots.txt协议

在抓取网站前,务必检查网站的robots.txt文件,了解哪些页面可以被抓取,哪些不可以。遵守协议是合法抓取的基础。

2. 处理相对路径

提取到的链接可能是相对路径,需要转换为绝对路径。可以使用`urllib.parse.urljoin`(Python)或相应的方法进行处理。

3. 应对反爬虫机制

许多网站有反爬虫机制,如验证码验证、IP封锁等。遇到这些问题时,可以尝试调整请求频率、使用代理IP、模拟用户行为(如设置User-Agent、Cookies等)等方法。

4. 数据存储与清洗

提取到的链接可能包含重复、无效或不需要的链接,需要进行后续的数据清洗和存储。可以使用数据库、CSV文件等方式存储数据。

结论

通过以上方法,你可以高效地获取网页中的全部链接。无论你是Python开发者、JavaScript爱好者,还是自动化测试工程师,都能找到适合自己的工具和方法。在实际应用中,结合多种技术和策略,可以更好地应对各种网页结构和反爬虫机制,实现高效、稳定的链接抓取。记住,合法合规是前提,尊重网站的所有权和隐私政策,共同维护网络生态的健康与繁荣。

- 上一篇: 河北人社如何进行认证?

- 下一篇: 如何在中国移动APP上查询自己名下的手机号码?

-

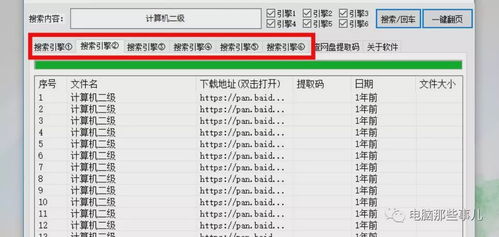

如何获取网盘文件的提取码?资讯攻略11-25

如何获取网盘文件的提取码?资讯攻略11-25 -

如何在微信中设置使用系统默认浏览器打开网页链接资讯攻略12-05

如何在微信中设置使用系统默认浏览器打开网页链接资讯攻略12-05 -

怎样能一键删除微博上的所有私信?资讯攻略11-24

怎样能一键删除微博上的所有私信?资讯攻略11-24 -

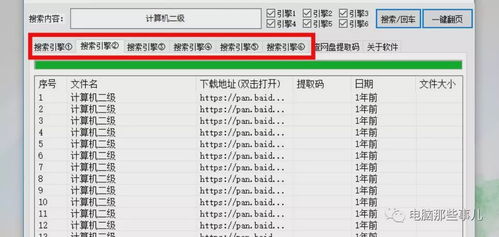

如何获取一个网站的所有链接地址?资讯攻略11-23

如何获取一个网站的所有链接地址?资讯攻略11-23 -

如何获取并查看个人提取码资讯攻略11-20

如何获取并查看个人提取码资讯攻略11-20 -

掌握一键复制网页链接的绝技!资讯攻略12-02

掌握一键复制网页链接的绝技!资讯攻略12-02